笔者最近学了点seo,发现网站还是过于简陋了,难怪百度一直不收录

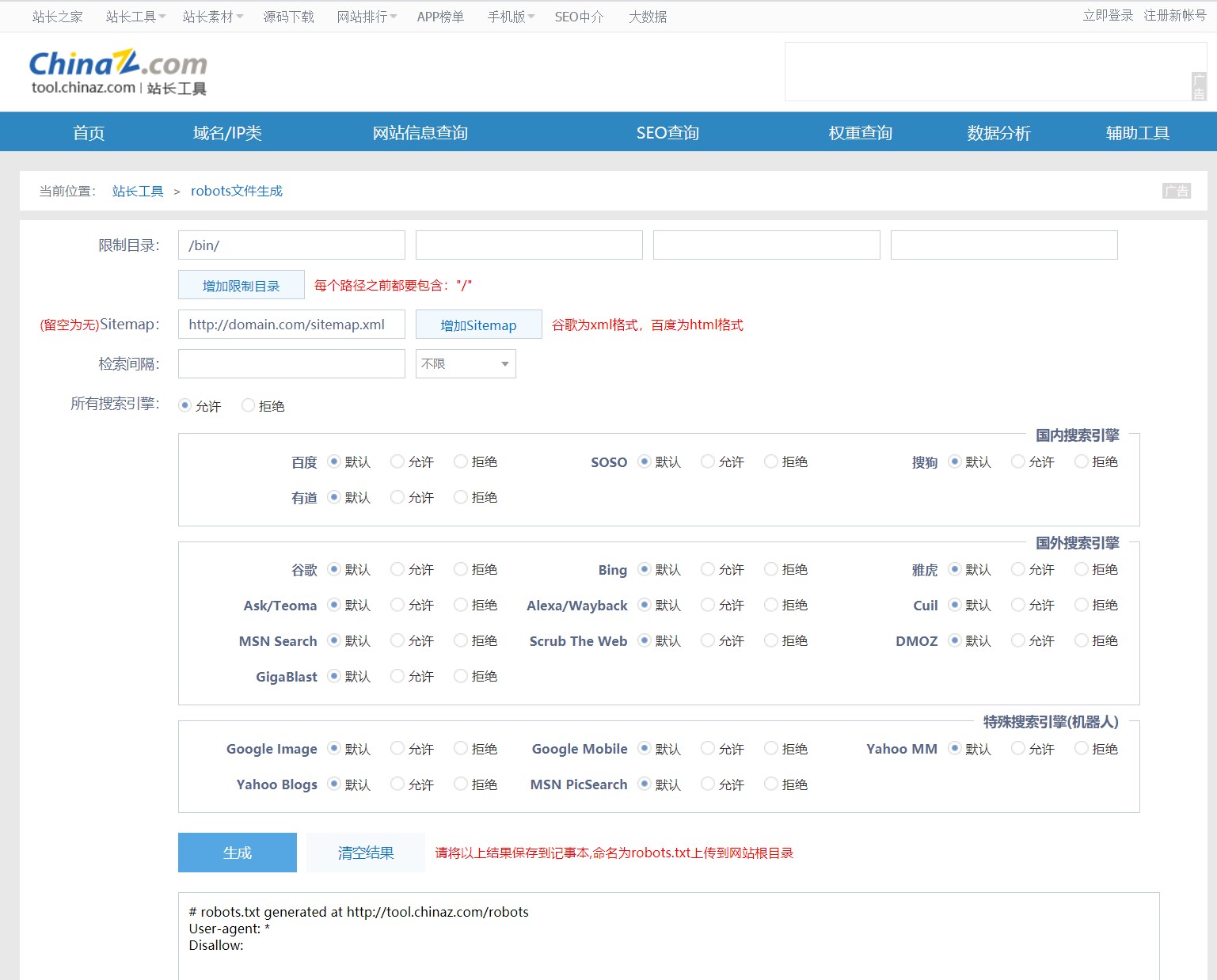

Robots.txt设置

现在准备来写一下robots文件

这里推荐一下站长工具

通过它可以快速设置robots.txt文件

限制目录是指限制搜索引擎不进行收录的目录,在这里我设置成了后台的登陆界面

选择完毕之后点击生成,复制底下的文字,在服务器中生成一个robots.txt文件,将复制的内容粘贴进去就可以了。

Sitemap.xml设置

这里由于笔者是使用wordpress,就分为wordpress和非wordpress了

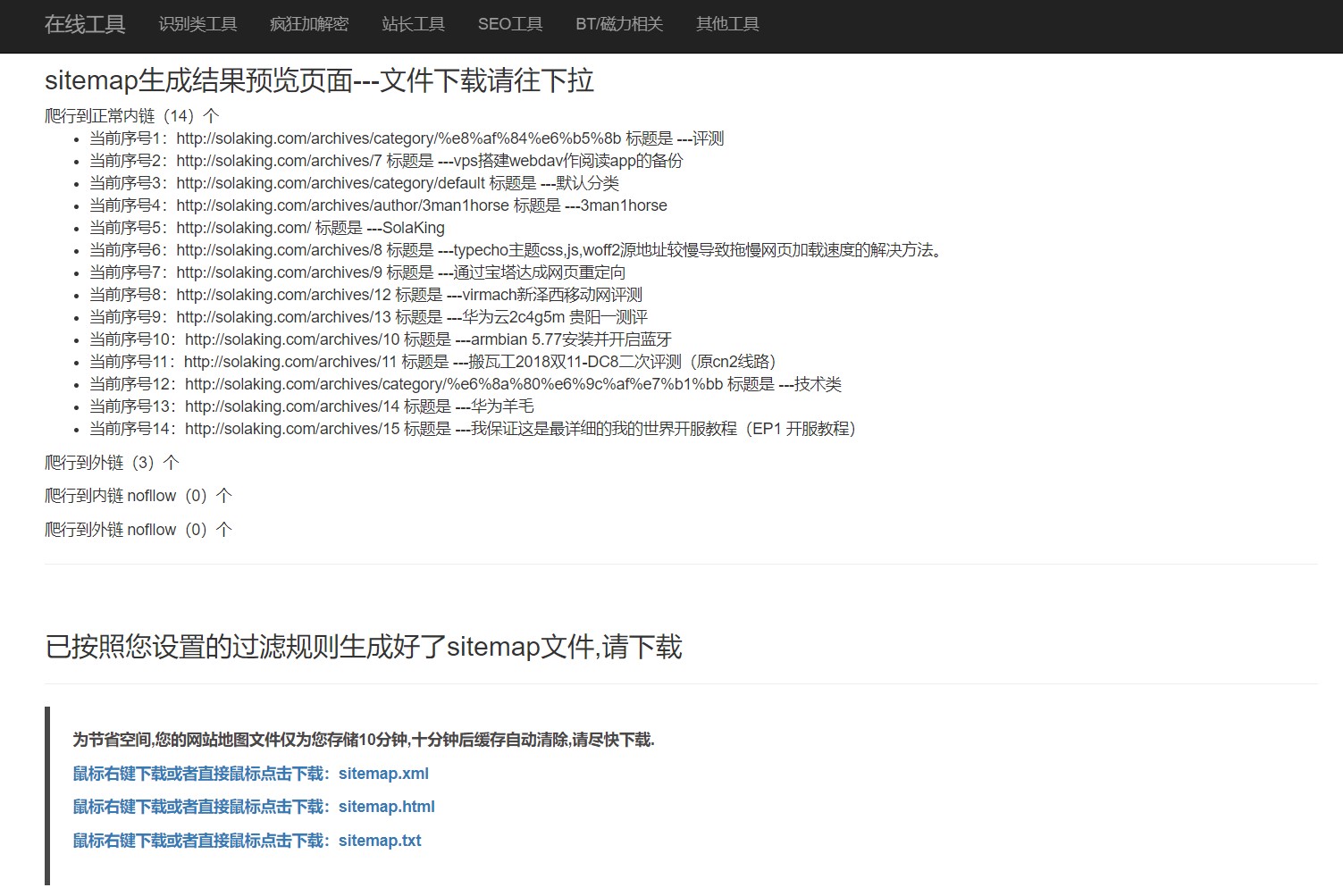

非wordpress

这里笔者使用的是这个网站bugscaner,非常快捷

使用起来很方便,可以一键生成xml和html,txt文件,点击一键下载上传即可

记得放入网站的根目录

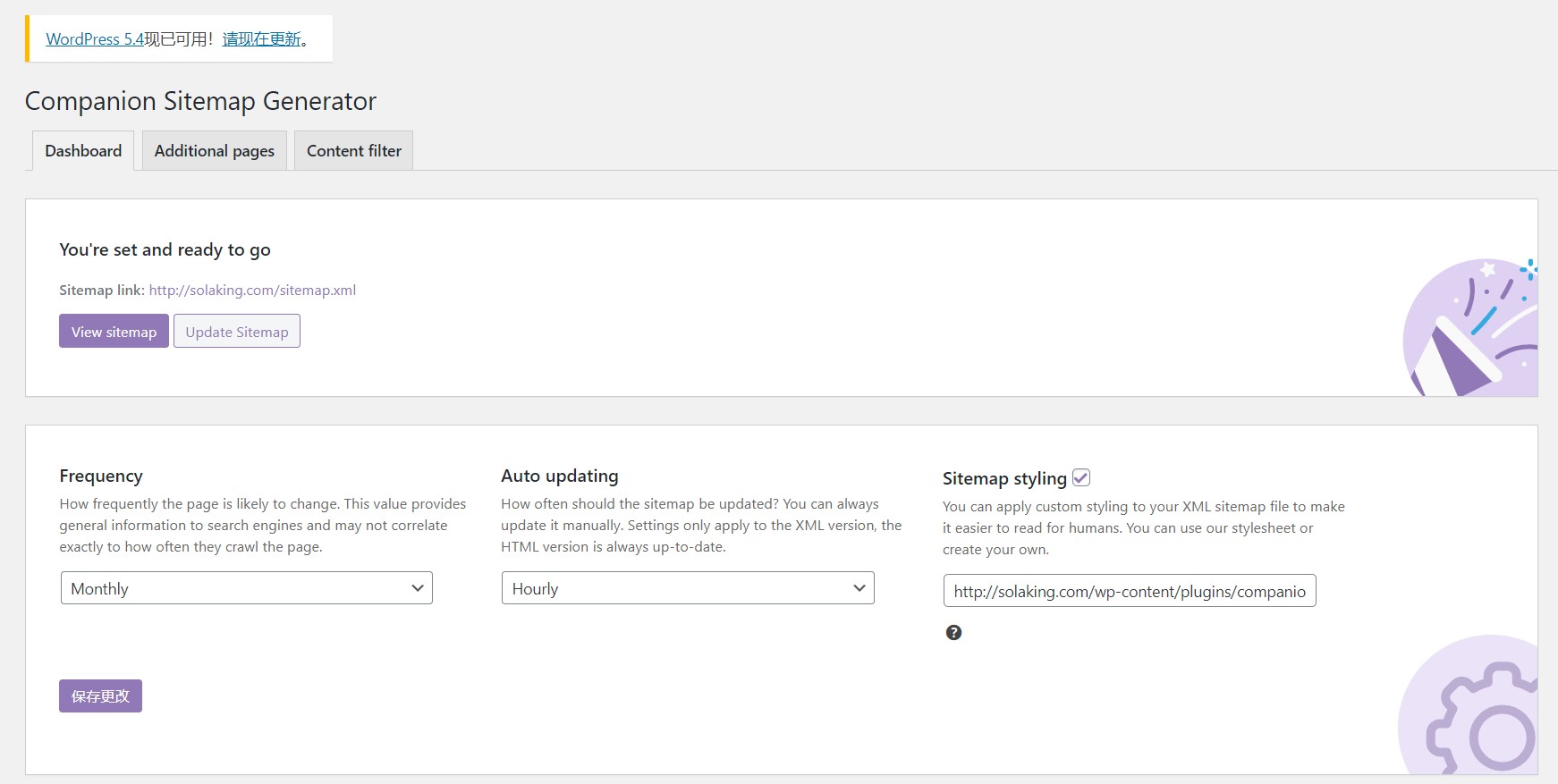

Wordpress篇

在这里,笔者直接使用了wordpress自带的插件

在wp后台界面中,选择插件-安装插件,搜索 Companion Sitemap Generator这个插件。点击安装,可能会显示too many requests,不管他,等一会就好了

再点击setting

在dashboard界面可以设置sitemap文件更新的周期

在content filter中可以选择排除不想被收录的目录,如category等

以上就是所有内容啦!